(2026 2 月 最新版)Codex CLI 国内使用教程,手把手教你如何支付、安装最新GPT5模型的Codex!

一、国内使用 Codex & Code Cli 教程

三个月前,我的日常主力还是 Cursor,一个月前换成了 Claude Code ,但「降智」+ 封号 + A 社逆天发言之后后,我开始寻找备胎。

一周前 OpenAI 突然宣布:ChatGPT Plus 用户无需 API Key,直接登录就能用 Codex CLI,我立刻冲了回去。

并且全网都在说这次 openai 编码能力提升很大,所以安装了一波 Codex Cli,结果越用越上头,于是有了这篇「踩坑 + 对比」流水账,方便大家初次使用。

但是先说目前 Codex 和 Claude Code 一样需要付费才能使用(Pro、Plus、Business 都可以),如果你还是免费用户,可以试试这个一键升级工具:

国内自助升级 ChatGPT Plus 工具: getgpt.pro , 详细教程 国内升级 ChatGPT 手把手教程

如果你还没 ChatGPT 账户,可以去用谷歌邮箱、微软邮箱等注册一个,或者直接在这里几块钱购买一个成品账号登录都可以:

另外,最近 codex 新用户较多,建了一个 codex 的交流群,大家可以互相交流经验:

二、哪些用户可以用 Codex?

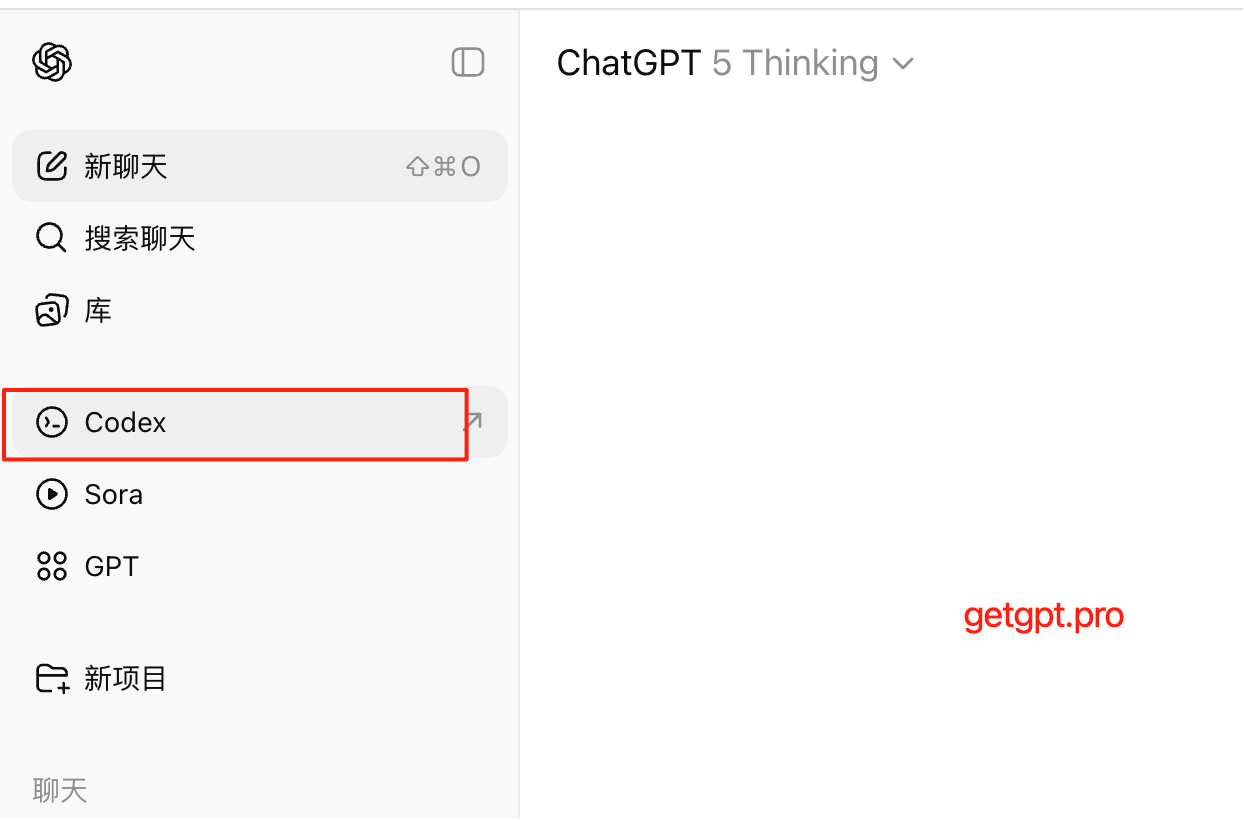

目前 ChatGPT Plus、Team、Pro 等付费会员都可以使用,直接在网页版就有 Codex 入口:

三、Codex 有哪些使用场景?

点开之后页面如下:

1. 连接到 GitHub

- 用途:将 Codex 和你的 GitHub 账户或仓库连接。

- 场景:自动生成 PR、修复 issue、基于代码库上下文写代码。

2. 连接存储库以创建任务

- 用途:让 Codex 读取你的项目代码,理解结构。

- 场景:重构代码、添加新功能、写测试、生成文档等。

3. 使用 Codex

这是入口部分,提供了几种使用方式:

✅ 终端上试用(CLI)

这就是 Codex Cli、对标 Claude Code

- 适合:喜欢命令行、自动化脚本、批量处理任务。

- 特点:轻量、快速、可集成 CI/CD。

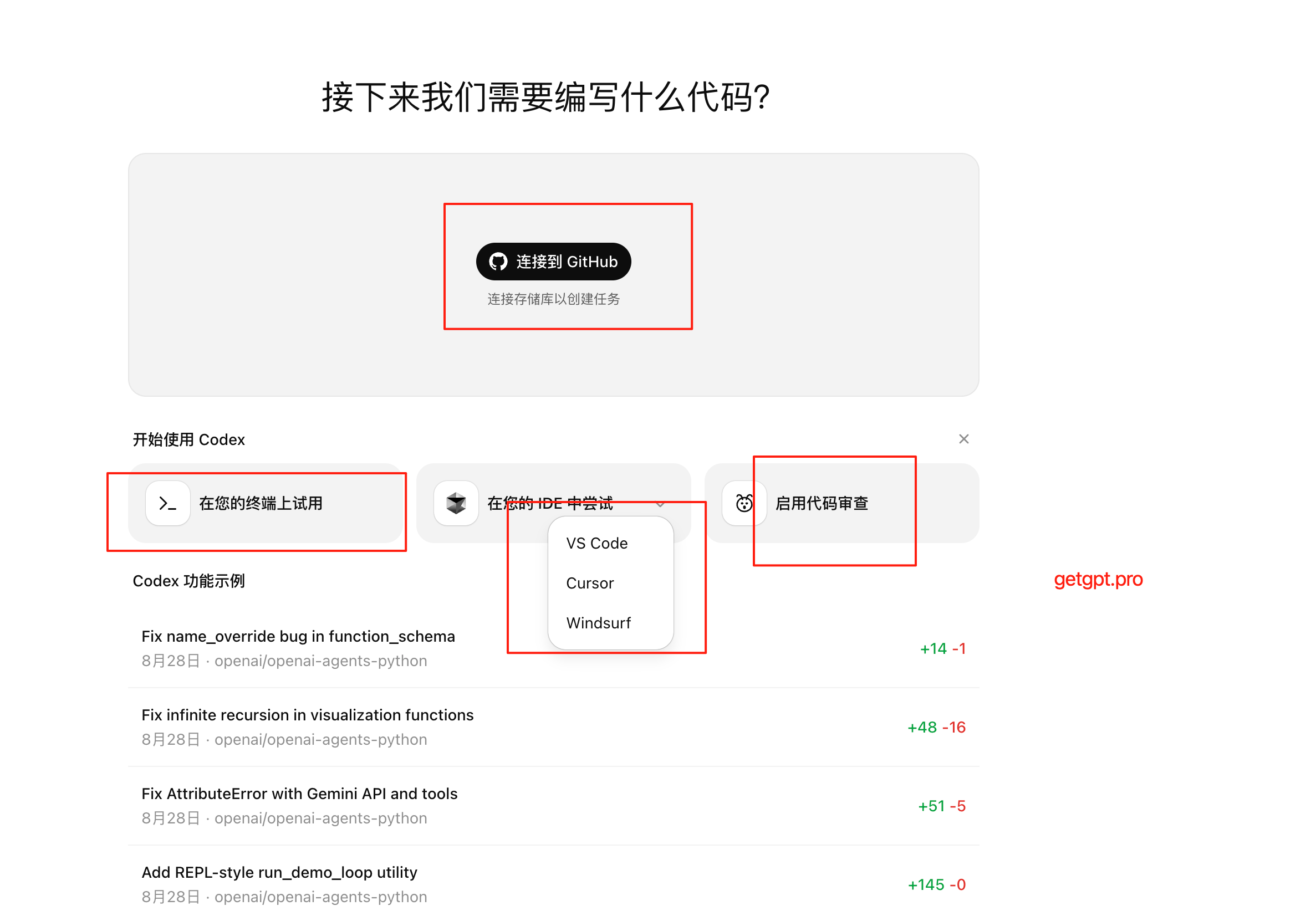

✅ 在您的 IDE 中尝试

- 支持 VS Code、Cursor、Windsurf 等。

- 特点:图形界面友好,适合日常开发、边写边问。

二、30 秒安装 Codex Cli(真的只要 30 秒)

# 1. 确保 Node ≥ 22

node -v # v22.5.1

# 2. 一行命令搞定

npm i -g @openai/codex

# 3. 验证

codex --version # 0.36.0国内 NPM 慢?两条路:

npm i -g @openai/codex --registry=https://registry.npmmirror.com- 或者

brew install codex(Homebrew 已同步最新版)

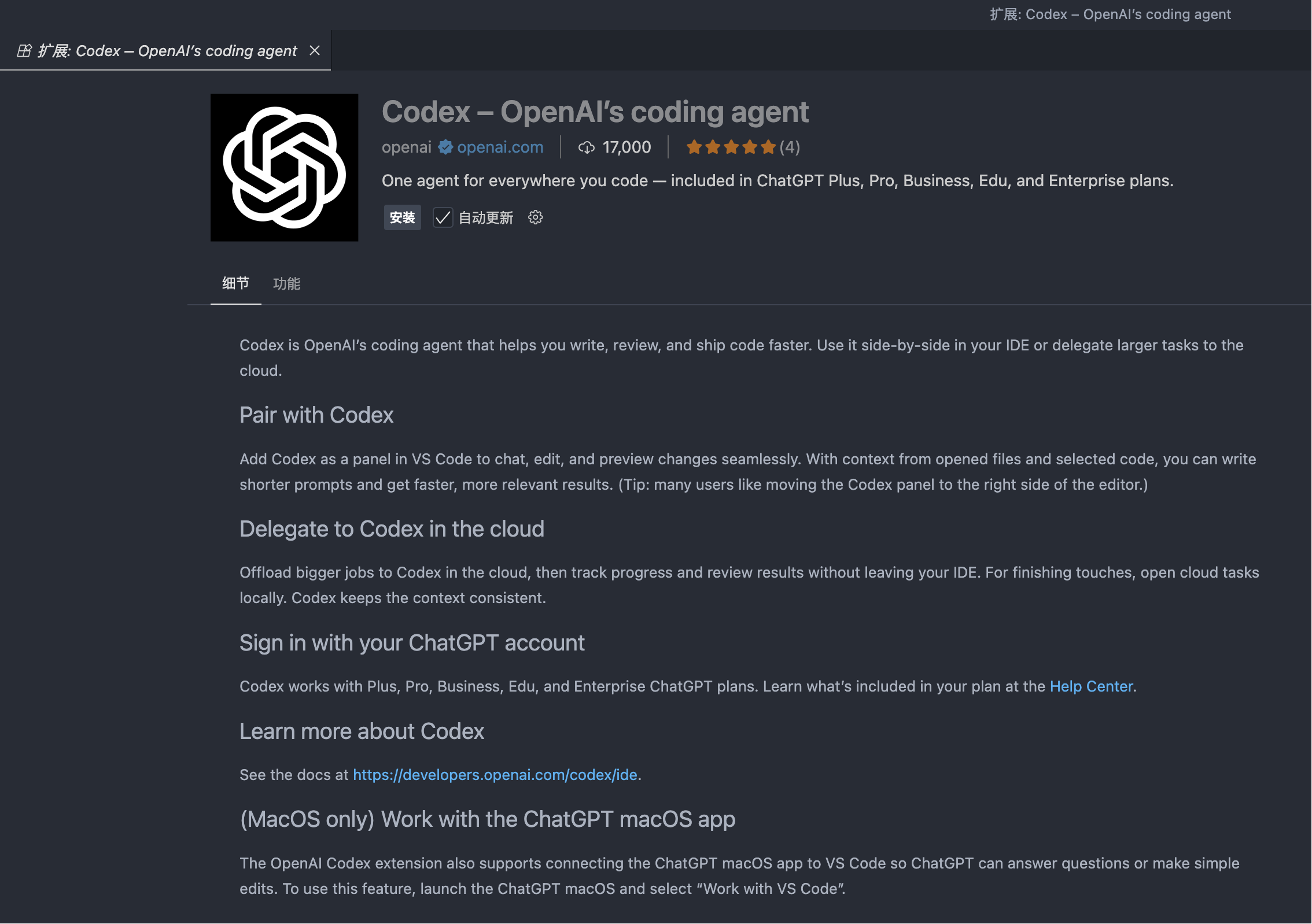

不习惯 Cli 的可以去 Cursor、VSCode 装插件:

三、零配置启动:浏览器点一下就能玩

命令行输入:

codex首次会弹网页,用 ChatGPT 账号一键登录 → 自动写回 ~/.codex/token,全程不用复制粘贴任何 Key。

(Plus/Pro/Edu/Team 都能用,免费账号不行。)

四、10 行命令带你飞

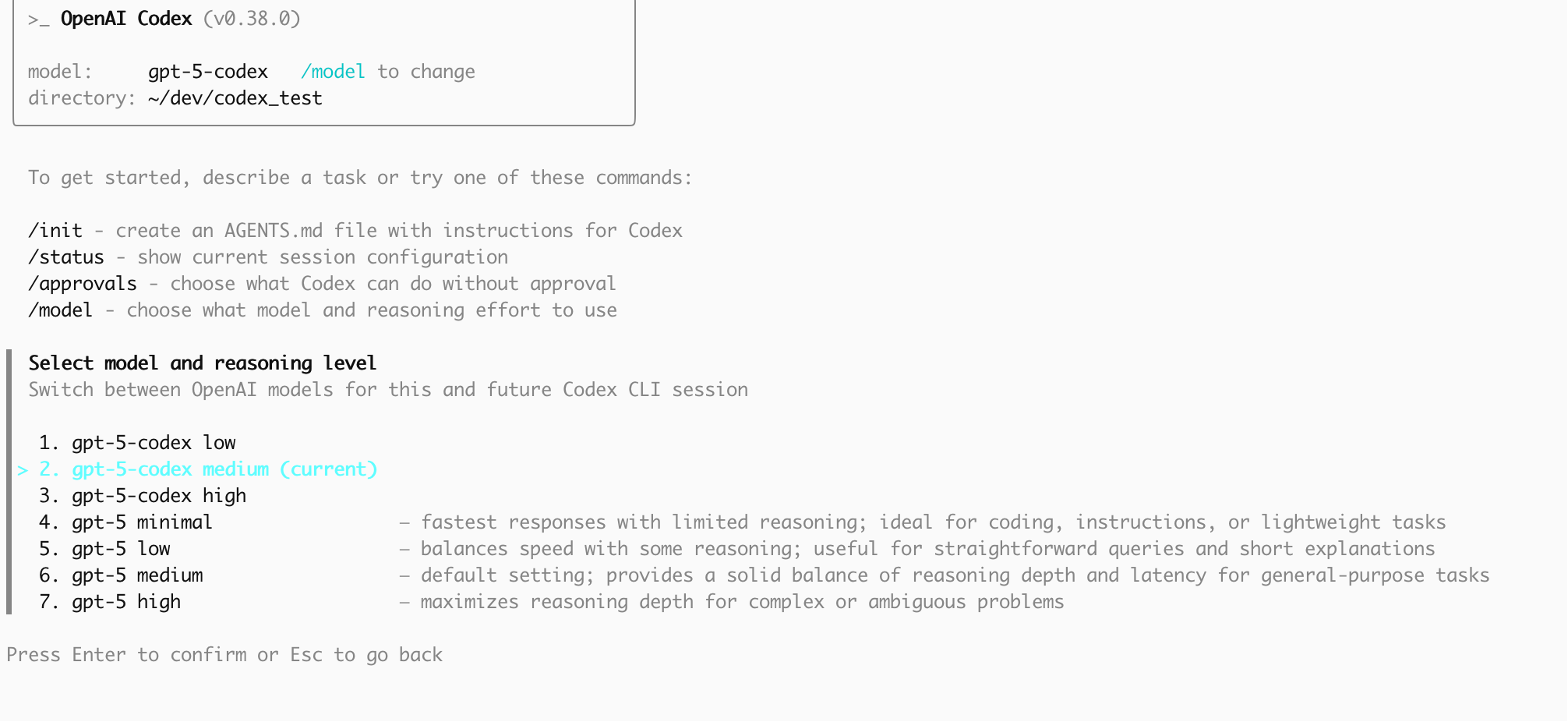

登录运行之后,可以 用 /model 指令切换模型,默认是 GPT5-codex medium

更多的指令整理如下:

| 场景 | 输入 | 我的体感 |

|---|---|---|

| 1. 直接下指令 | codex "写一个下载文件的 Python 脚本" | 3 s 出代码,0 句废话 |

| 2. 交互模式 | codex 回车 → >> 把上面的脚本改成并发 | Tab 补全、Ctrl-R 搜历史,手感像 zsh |

| 3. 图片报错 | codex -i error.png "修掉图中的报错" | 能读终端截图,省掉手打错误信息 |

| 4. 整仓重构 | codex "给整个 Go 项目加 ctx 传值" | 先出计划 → 让我批每一块 Diff → 再批量应用,安全感 +1 |

| 5. 一键运行 | codex exec "跑通 pytest" | 自动 pip install → 跑测试 → 回退失败的 commit,CI 即视感 |

五、真实对比:Codex vs Claude Code vs Qwen Coder

| 维度 | Codex (GPT-5) | Claude Code (Opus 4.1) | Qwen3-Coder |

|---|---|---|---|

| 登录门槛 | Plus $20/月 直接登 | 需美区账号 + 手机接码,已明确封国内 IP | 开源,本地可跑,账号 0 成本 |

| 速度 | 首 token 1.2 s,话少聚焦 | 2.5 s 左右,喜欢先「分析+总结」 | 本地 4090 推理,首 token 0.8 s,但大模型 480B 显存吃紧 |

| 上下文 | 官方没说,实测 200k 级别,能读整个 Laravel 仓库 | 100k~1M 可调,子代理拆任务后更省 | 256k 原生,可扩 1M,长仓扫描无压力 |

| 目录洁癖 | 给目录图就照图施工,几乎不乱放文件 | 偶尔「自作主张」合并成单文件 | 中文 prompt 下也爱整单文件,需要额外强调分层 |

| 工程化 | 计划面板 + 手动批准,Hooks 社区在 PR | Slash + Hooks + Subagents 三件套成熟 | 暂无生态,全靠用户自己拼脚本 |

| 前端审美 | 能用,但 UI 细节直男 | 动画、渐变、响应式一把梭 | 比 Codex 还「理工男」,需要设计师拯救 |

| 价格 | 绑在 Plus,不限量但 3 h 40 次「深度」 | $20-200 梯度,封号风险高 | 开源权重免费,电费自己掏 |

| 隐私 | 云端沙盒,代码短暂驻留 | 本地执行,绝对私密 | 本地执行,可完全离线 |

六、我最常用的 3 条「高级」姿势

只读模式先探路

默认ask权限,不会动你文件,先让它出方案,再codex --auto批量执行。VS Code 联动

装 Codex Companion 插件,侧边栏@codex直接对话,Alt+G 把选中代码扔进 CLI,无需复制。会话持久化

交互里随时/export session.json,第二天/load session.json继续上下文,适合超长重构。

七、目前仍踩得到的坑

| 问题 | 临时解法 |

|---|---|

| 深度思考限次 | 3 h 40 次,用完切「标准」模式凑合 |

| 文档分散 | 官方只有 developers.openai.com/codex/cli,社区版手册在 Notion 同步更新 |

| 国内网络偶发 502 | 开系统代理后 export HTTPS_PROXY=http://127.0.0.1:7890 即可 |

八、一句话总结(省流版)

我现在的工作流:

「Codex 快速出原型 → 本地 Git 提交 → Claude Code 做 Code Review + 写单测」

双剑合璧,效率比纯人工翻三倍,成本比雇一个实习生便宜 95%。

如果你还是免费用户,可以试试这个一键升级工具:

国内自助升级 ChatGPT Plus 工具: getgpt.pro

九、继续深挖的链接清单

- OpenAI 官方 CLI 仓库(Star 14k,更新极快)

- Qwen3-Coder 权重下载(BF16 & 4-bit 全都有)

祝你也能 5 分钟把 AI 装进终端,早点下班,多陪猫。